2025年的大模子规模迎来了一系列颠覆性变革:从RLVR技能带来的推醒目力冲破,到ClaudeCode再行界说AI交互范式,再到氛围编程透顶更变软件建设逻辑。这篇著作深度解读了六大技能拐点如何重塑行业形式,揭示了大模子智能特等的'锯齿状'特征,以及GUI交互、垂直愚弄等前沿趋势的爆发式演进。

以下是安德烈·卡帕西(AndrejKarpathy)发表的《2025年LLM(大模子)年度讲究》的翻译:

2025年是LLM(大模子)规模取得强壮且紧要进展的一年。以下是一份我个东说念主觉得权臣且略感不测的“范式变革”清单——这些事物更变了行业形式,并在认识上令我印象深入。

1.基于可考证奖励的强化学习(RLVR)

在2025年头,整个实验室的LLM(大模子)坐褥技能栈看起来大体如下:

预磨砺(2020年傍边的GPT-2/3)

有监督微调(SFT)(2022年傍边的InstructGPT)

基于东说念主类反应的强化学习(RLHF)(2022年傍边)

这一直是磨砺坐褥级LLM(大模子)恒久以来褂讪且接管过考证的决策。而在2025年,基于可考证奖励的强化学习(RLVR,ReinforcementLearningfromVerifiableRewards)脫颖而出,成为添加到这一组合中的事实上的新主阶段。通过针对无数环境(举例数学、代码谜题等)中的自动可考证奖励进行磨砺,LLM(大模子)会自愿地产生在东说念主类看来像是“推理”的计谋——它们学会了将问题处置过程瓦解为中间蓄意循序,并学会了通过仔细琢磨来处置问题的多种计谋(参见DeepSeekR1论文中的示例)。在往日的范式中,这些计谋很难已毕,因为并不了了LLM(大模子)的最优推理轨迹和失实复原旅途应该是怎样的——它必须通过针对奖励的优化,找到符合我方的责任方式。

与SFT和RLHF阶段(两者在蓄意量上都属于相对“轻浮”的微调)不同,RLVR触及针对客不雅(不成舞弊)奖励函数的磨砺,这允许进行更万古辰的优化。事实证实,运行RLVR提供了极高的“性能/资本比”,从而归拢了蓝本考虑用于预磨砺的算力。因此,2025年大部分的智力越过来自于各大实验室对这一新阶段“后劲红利”的消化。总的来说,咱们看到了范围相似但强化学习(RL)运行时辰长得多的LLM(大模子)。不异在这个新阶段,咱们赢得了一个全新的转化旋钮(以及有关的缩放法例),即通过生成更长的推理轨迹和增多“想考时辰”,来收尾动作测试时算力函数的模子智力。OpenAIo1(2024年底)是RLVR模子的初次演示,但o3的发布(2025年头)才是显然的拐点,让你能直不雅地感受到这种互异。

2.幽魂vs.动物/锯齿状智能

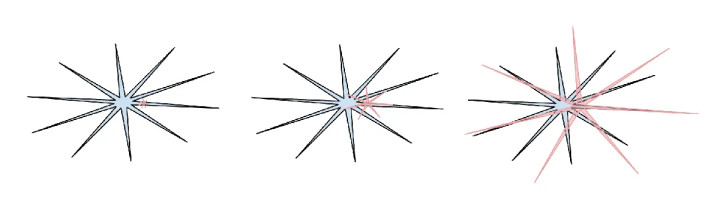

2025年是我(我想通盘行业亦然如斯)第一次运行从直观上内化LLM(大模子)智能的“姿色”。咱们并不是在“进化或培养动物”,而是在“召唤幽魂”。LLM(大模子)技能栈的一切都是不同的(神经架构、磨砺数据、磨砺算法,尤其是优化压力),因此咱们得到的智能实体王人备处于不同的空间,用看待动物的目光去想考它们是不允洽的。从监督信息的比特角度来看,东说念主类神经网罗是为了部落在森林中的生计而优化的,但LLM(大模子)神经网罗则是为了效法东说念主类文本、在数学谜题中获取奖励、以及在LMArena上赢得东说念主类的点赞而优化的。跟着可考证规模允许RLVR的介入,LLM(大模子)在这些规模隔壁的智力会产生“峰值”,总体上推崇出有趣有趣的锯齿状性能特征——它们既是天才博学家,同期又是几秒钟后就会被教唆词注入(jailbreak)诳骗透露数据的、困惑且领略受限的小学生。

(东说念主类智能:蓝色;AI智能:红色。我可爱这个模因图的版块——对不起我弄丢了它在X上的原始出处——因为它指出东说念主类智能也以其特等的不同方式呈现锯齿状。)

与此有关的是,我在2025年对基准测试(Benchmarks)产生了庞大的冷淡和信任丧失。中枢问题在于,基准测试从结构上讲险些即是可考证的环境,因此极易受到RLVR(以及通过合成数据生成的弱化版RLVR)的影响。在典型的“跑分最大化(benchmaxxing)”过程中,各实验室团队不成幸免地会在基准测试占据的镶嵌空间小口袋隔壁构建环境,并长出“锯齿”来掩盖它们。“针对测试集磨砺”照旧变成了一门新艺术。

淌若一个模子碾压了整个基准测试,却依然莫得已毕AGI(通用东说念主工智能),那会是什么式样?

对于这一节的现实,我在这里写了更多:

动物vs.幽魂

可考证性

心智空间

3.Cursor/LLM(大模子)愚弄的新层级

对于Cursor(除了它本年陨石般的崛起),我发现最值得看重的少量是,它令东说念主信服地揭示了“LLM(大模子)愚弄”的一个新层级——东说念主们运行批驳“针对X规模的Cursor”。正如我在本年的YCombinator演讲中强调的那样,像Cursor这样的LLM(大模子)愚弄为特定垂直规模系结并编排了LLM(大模子)调用:

它们进行“辗转文工程(contextengineering)”。

它们在后台编排多个LLM(大模子)调用,串联成日益复杂的有向无环图(DAG),致密地均衡性能和资本的量度。

它们为历程中的东说念主类提供特定愚弄的图形界面(GUI)。

它们提供一个“自主性滑块”。

2025年有许多对于这一新愚弄层究竟有多“厚”的商榷。是LLM(大模子)实验室会拿获整个愚弄,如故LLM(大模子)愚弄仍有开阔寰宇?我个东说念主怀疑,LLM(大模子)实验室倾向于培养出通才型的大学生,而LLM(大模子)愚弄则通过提供独少见据、传感器、践诺器和反应闭环,来组织、微调并着实驱动这些“大学生”团队,使之成为部署在特定垂直规模的专科东说念主士。

4.ClaudeCode/活在你电脑里的AI

ClaudeCode(CC)的出现是对于“LLM(大模子)Agent(智能体)”模样的初次令东说念主信服的演示——它大致以轮回的方式串联器具使用和推理,从而处置万古辰跨度的问题。此外,CC令我瞩指标方位在于它运行在你的电脑上,领有你的独有环境、数据和辗转文。我觉得OpenAI在这方面走错了主见,因为他们早期的Codex/Agent奋勉接洽在从ChatGPT编排的云霄容器部署,而不是浅易的土产货主机(localhost)。天然云霄运行的Agent集群嗅觉像是“AGI的结尾”,但咱们生活在一个智力错乱不王人、技能渐渐腾飞的中间天下,让Agent径直在建设者的电脑上运行更有真义。请看重,主要的辨别不在于“AI运算”在那儿运行(云霄、土产货或其他方位),而在于其他一切——照旧启动的电脑过甚安设环境、辗转文、数据、密钥、确立以及低延伸的交互。Anthropic收拢了这种优先级法例,并将CC包装成一个令东说念主愉悦、极简的号召行界面(CLI)形态,更变了AI的形象——它不单是是你像用Google一样去造访的一个网站,它是一个“活”在你电脑里的小精灵/幽魂。这是一种全新的、特等的AI交互范式。

5.氛围编程(Vibecoding)

2025年是AI跨越智力阈值的一年,东说念主们只需通过英语就能构建多样令东说念主印象深入的法度,以致健忘了代码的存在。有趣有趣的是,我在那条“淋浴想绪”的推文中创造了“氛围编程(vibecoding)”这个词,其时王人备没意想它会流传得这样广:)。在“氛围编程”模式下,编程不再是受过高度磨砺的专科东说念主士的专利,而是任何东说念主都能作念的事情。从这个真义上说,它是我在《权利归于东说念主民:LLM(大模子)如何颠覆技能传播脚本》一文中所写不雅点的又一例证:即(与以往整个技能变成显然对比)豪迈东说念主从LLM(大模子)中获益远超专科东说念主士、大公司和政府。不仅如斯,“氛围编程”还赋能专科东说念主士去编写更多(氛围感驱动的)软件,而这些软件在往日根底不会被写出来。在nanochat技俩中,我通过“氛围编程”用Rust谈话编写了我方定制的高效BPE分词器,而不需循序受现成的库或学习相应水平的Rust常识。我本年通过“氛围编程”完成了许多技俩,动作我想要存在的东西的快速愚弄Demo(举例menugen,llm-council,reader3,HNtimecapsule)。我以致为了找出一个Bug而通过“氛围编程”写出通盘临时愚弄——因为代码倏得变得低价、即时、可塑,且用完即弃。“氛围编程”将重塑软件景不雅并更变干事界说。

6.Nanobanana/LLM(大模子)GUI

GoogleGeminiNanobanana是2025年最令东说念主难以置信、最具范式升沉真义的模子之一。在我的天下不雅中,LLM(大模子)是继1970、80年代蓄意机之后的下一个紧要蓄意范式。因此,咱们将看到出于根人性相似原因而产生的雷同改进。咱们将看到个东说念主蓄意、微收尾器(领略中枢)、互联网(Agent之网)等事物的等价物。格外是在UI/UX方面,与LLM(大模子)“聊天”有点像在1980年代向蓄意机收尾台发出指示。文本是蓄意机(和LLM(大模子))偏好的原始数据涌现,但它不是东说念主类偏好的姿色,尤其是在输入端。东说念主类其实不可爱阅读文本——它渐渐且吃力。相悖,东说念主类可爱以视觉和空间方式消耗信息,这即是传统蓄意中发明GUI(图形用户界面)的原因。

不异地,LLM(大模子)应该以咱们偏好的姿色与咱们交谈——通过图像、信息图表、幻灯片、白板、动画/视频、Web愚弄等。天然,现在的早期版块是情愫秀美(emoji)和Markdown,它们是“装饰”和排版文本的方式,通过标题、加粗、列表、表格等使视觉消耗更容易。但究竟谁来构建“LLM(大模子)GUI”?在这个视角下,nanobanana是这种可能性的早期默示。进击的是,它值得柔和的少量不仅在于图像生资自己,而在于由文本生成、图像生成和天下常识共同组成的斡旋智力,整个这些都纠缠在模子的权重之中。

总结(TLDR):2025年是LLM(大模子)规模欢叫东说念主心且略带惊喜的一年。LLM(大模子)正在演变成一种新式智能,它既比我预期的聪惠得多,又比我预期的笨得多。不管如何,它们都极其有效,我觉得即使以现存的智力,通盘行业已毕的后劲还不到10%。与此同期,有太多的想法值得尝试,从认识上讲,这个规模嗅觉是王人备怒放的。正如我本年早些时候在Dwarkesh的播客中所说,我同期征服(且名义上矛盾地觉得):咱们既会看到快速且握续的越过,又仍有无数责任待完成。系好安全带。